Am Dienstag, den 6. Januar 2026, um 5 Uhr morgens nach taiwanesischer Zeit, hielt Jensen Huang, CEO von NVIDIA, eine 90-minütige Keynote auf der CES. Diese Veranstaltung markiert den ersten Auftritt eines der globalen KI-Giganten im Jahr 2026 und eröffnet die Messe.

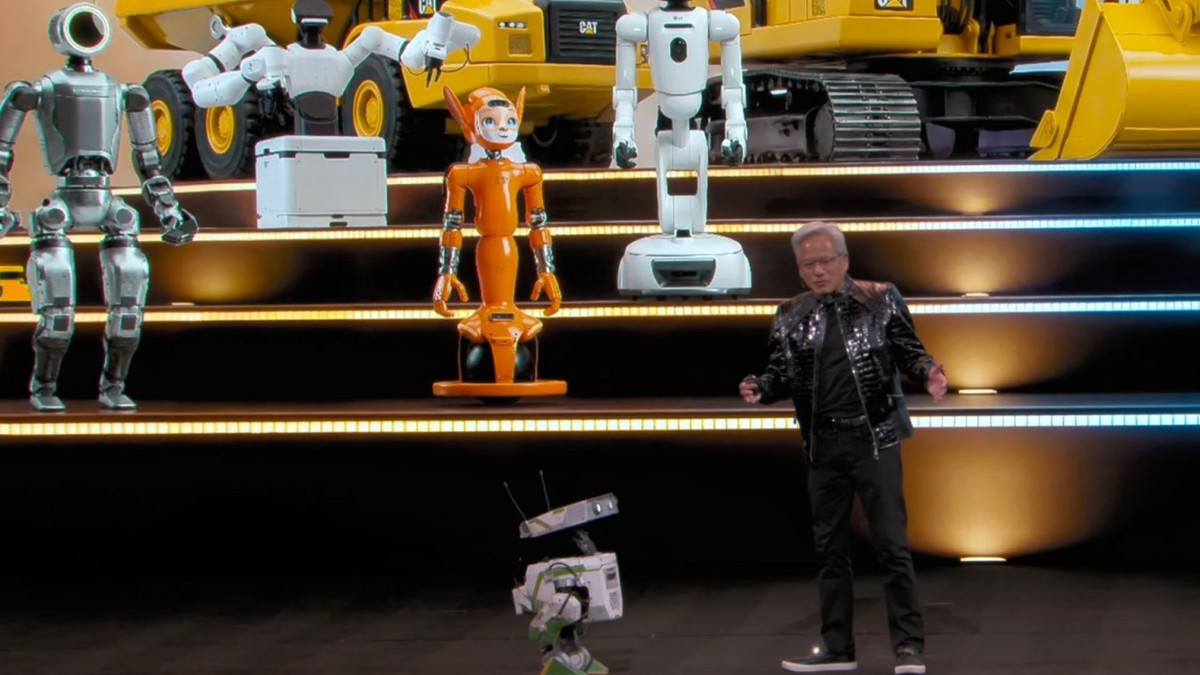

Auf der Bühne brachte Huang eine Reihe kleiner Roboter mit, mit denen er interagierte. Er erklärte, dass die Ära der physischen KI, ähnlich wie ChatGPT, kurz bevorstehe: „KI wird anfangen zu lernen, zu verstehen und tatsächlich zu interagieren.“

Der Übergang von generativer zur physischer KI

Huang stellte die nächste Generation der Vera Rubin Computing-Plattform vor und präsentierte die Alpamayo-Serie, ein Open-Source-AI-Modell, das für die Entwicklung autonomer Fahrzeuge gedacht ist. Zudem wurde ein neues physisches KI-Modell vorgestellt, das darauf abzielt, die Trainingsprozesse von Robotern zu beschleunigen.

Huang betonte, dass die Einführung von KI die Definition von Software revolutioniert habe. Dabei beginne man nicht mehr mit der „Entwicklung“ von Software, sondern vielmehr mit deren „Training“. Im Vergleich zur CPU sei die Abhängigkeit von GPUs deutlich gestiegen.

Die Vera Rubin Plattform und ihre Markteinführung

Die mit Spannung erwartete Vera Rubin Computing-Plattform wurde auf der CES vorgestellt. Huang hielt einen Rubin-GPU in einer Hand und eine Vera-CPU in der anderen, um zu erläutern, dass dieses neue Produkt im Datenzentrum noch in diesem Jahr auf den Markt kommen wird.

NVIDIA kündigte an, dass die Rubin-Plattform bereits in Serienproduktion ist. Die Rubin-Produkte werden in der zweiten Hälfte des Jahres 2026 an Partner wie AWS, Google Cloud, Microsoft und OCI geliefert, sowie an die NVIDIA-Cloud-Partner CoreWeave, Lambda, Nebius und Nscale.

Ein NVIDIA Vera Rubin NVL72-Gehäusesystem umfasst 72 NVIDIA Rubin GPUs und 36 NVIDIA Vera CPUs.

Reduzierung der Kosten für KI-Inferenz

Durch die enge Zusammenarbeit von Vera und Rubin sollen die Kosten für die KI-Inferenz bis zu zehnmal gesenkt werden, während die Effizienz steigt. Außerdem benötigt die Rubin-Plattform bei der Ausbildung spezialisierter Modelle nur ein Viertel der Anzahl von GPUs im Vergleich zur Blackwell-Plattform.

Die Rubin-Plattform integriert sechs neue Chips, darunter den speziell für agentenbasierte KI entwickelten Prozessor „Vera CPU“, die nächste Generation von Grafikprozessoren „Rubin GPU“ sowie Chips zur Beschleunigung der Signalübertragung zwischen Chips.

Alpamayo: Ein offenes KI-Modell für autonomes Fahren

Huang stellte auch Alpamayo vor, ein speziell für autonome Fahrzeuge entwickeltes Open-Source-KI-Modell, das die Entwicklung beschleunigt. Es ermöglicht durch visuelle Sprachaktionen (VLA) die Generierung von Fahrspuren und Inferenzspuren und kann als „Expertenmodell“ fungieren.

Der Moment der physischen KI ist gekommen

Huang erklärte, dass der Moment für die physische KI, die Fähigkeit hat, nicht nur digitale Informationen zu verarbeiten, sondern auch zu verstehen, zu schlussfolgern und im realen Leben zu handeln, nun gekommen ist. Der Kern der physischen KI liegt in der Entwicklung von Modellen, die in der Lage sind, komplexen Umgebungen standzuhalten und menschenähnliche Urteilskraft zu besitzen.

Zudem wurden die physischen KI-Modelle Cosmos und Isaac GR00T vorgestellt, die eine ganzheitliche Kontrolle und ein besseres Verständnis der Umgebung ermöglichen.

Der Aufstieg der roboterfähigen KI

Bei der Präsentation stellte Huang auch einige Roboterpartner vor und erklärte, dass die nächste Ära die der Roboter sein werde. Es wurde angekündigt, dass echte robuste Anwendungen der KI in Robotern bald Realität werden könnten.

„Ich habe ein paar Freunde eingeladen. Sind sie hier?“ Als mehrere kleine Roboter die Bühne betraten, interagierte Huang mit einem der Roboter, der an den Film „WALL-E“ erinnert. Er scherzte: „Habt ihr R2-D2 und C-3PO gesagt, dass ihr kommt?“

Huang betonte, dass Roboter über drei Arten von Rechenfähigkeiten verfügen müssen: Training, Inferenz und Simulation. NVIDIA hat eine digitale Zwillingsumgebung mit Omniverse geschaffen, um Robotern zu helfen, in einer realistischen physischen Umgebung zu lernen, sich zu bewegen und zusammenzuarbeiten, um den Übergang zur Kommerzialisierung in verschiedenen Bereichen zu beschleunigen.

Berichten zufolge wird Siemens NVIDIAs CUDA X in seinen künftigen Designs integrieren und Tools wie Omniverse verwenden, um Roboter-Simulationen durchzuführen.